近期Deepseek官网频繁出现“服务器繁忙,请稍后再试”,而近期各大厂商都纷纷推出Deepseek满血版API接口,实测可用。本教程将结合Chatbox AI客户端+Deepseek API,教你打造稳定可用的Deepseek-R1智能推理助手。

一、准备工作

1.1 软件下载并安装

Chatbox客户端:点击下载 依次访问目录 (常用软件合集->ChatBox AI)

我已经整理了Windows、MacOS、Linux、安卓的完整安装包。苹果手机的话,进AppStore中直接搜索“Chatbox”就可以下载。

1.2 API密钥获取

API密钥获取有多个渠道,推荐几个常用的渠道,可以都作为备选项去使用(DeepSeek-R1的算力要求极高,且最近热度很高,几乎所有API厂商的接口都算不上稳定,用不了就切换下一个接口就好)。

- 腾讯云:进入腾讯云官网,注册并登录账号,然后进入“知识引擎原子能力”控制台,使用OpenAI SDK方式接入创建密钥。

- 硅基流动:进入硅基流动官网注册并登录账号,点击左侧菜单的“API 密钥”,然后新建API密钥。

- MKEAI API中转站:进入MKEAI API中转站注册并登录账号,点击左侧菜单的“我的令牌”,添加令牌。

- 其他的就不一一列出来了,只要API厂商介绍的支持openai通用格式的,都能使用。

二、Chatbox配置

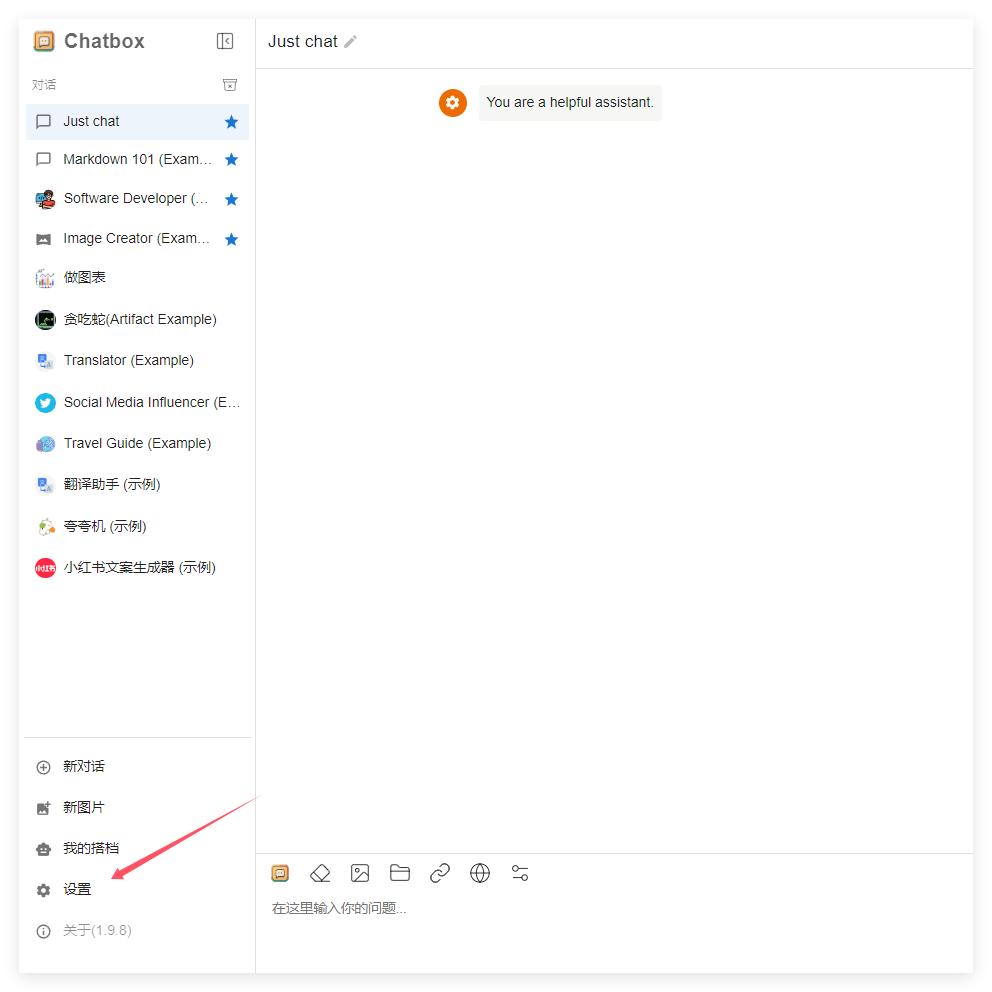

1、打开Chatbox电脑客户端(手机端类型,自己摸索一下),首先点击左下角的设置

2、模型提供方选择OpenAI API,API密钥填写刚刚在API厂商那里创建的API密钥(令牌)。API域名填写: https://search-for-llmapi.dawne.cn/with-search/v1 ,记住必须填写这个地址,这是从github上找到的一个开源项目提供的AI搜索中转接口,可以直接用来实现联网搜索,github上也有开源项目,可以自己本地部署这个搜索接口,这里就不多介绍了。

3、下面重点来了:

- 模型选择自定义模型,会出来自定义模型名的输入框,如果你用的是硅基流动的API,填写格式为:

siliconflow@模型名称,例如siliconflow@deepseek-ai/DeepSeek-R1,如下图:

硅基流动提供了多个模型,直接替换模型名就可以使用其他AI模型+联网搜索了。 硅基流动模型列表:https://cloud.siliconflow.cn/models

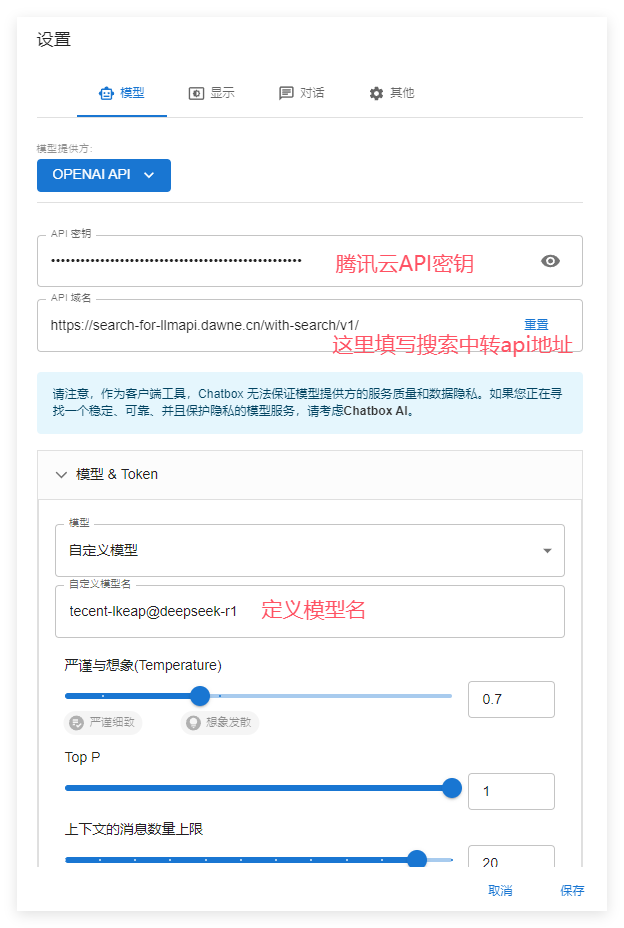

- 如果用的是腾讯云的API,自定义模型名输入:

tecent-lkeap@模型名称,例如tecent-lkeap@deepseek-r1,腾讯云的api支持deepseek-v3和deepseek-r1两个模型。如下图:

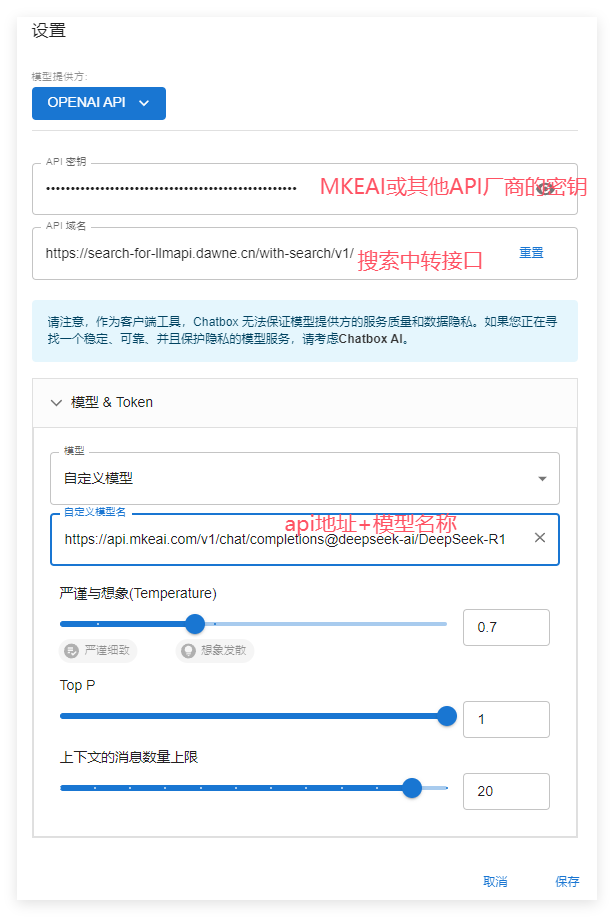

- MKEAI API中转(所有OpenAI API格式的API厂商都通用)

自定义模型名输入:api地址@模型名称,例如: https://api.mkeai.com/v1/chat/completions@deepseek-ai/DeepSeek-R1,同样MKEAI API中转站支持多个AI大模型,可以替换模型名称来实现联网搜索功能。

模型列表: https://api.mkeai.com/pricing (点击列表前面的模型名称就可以复制了)

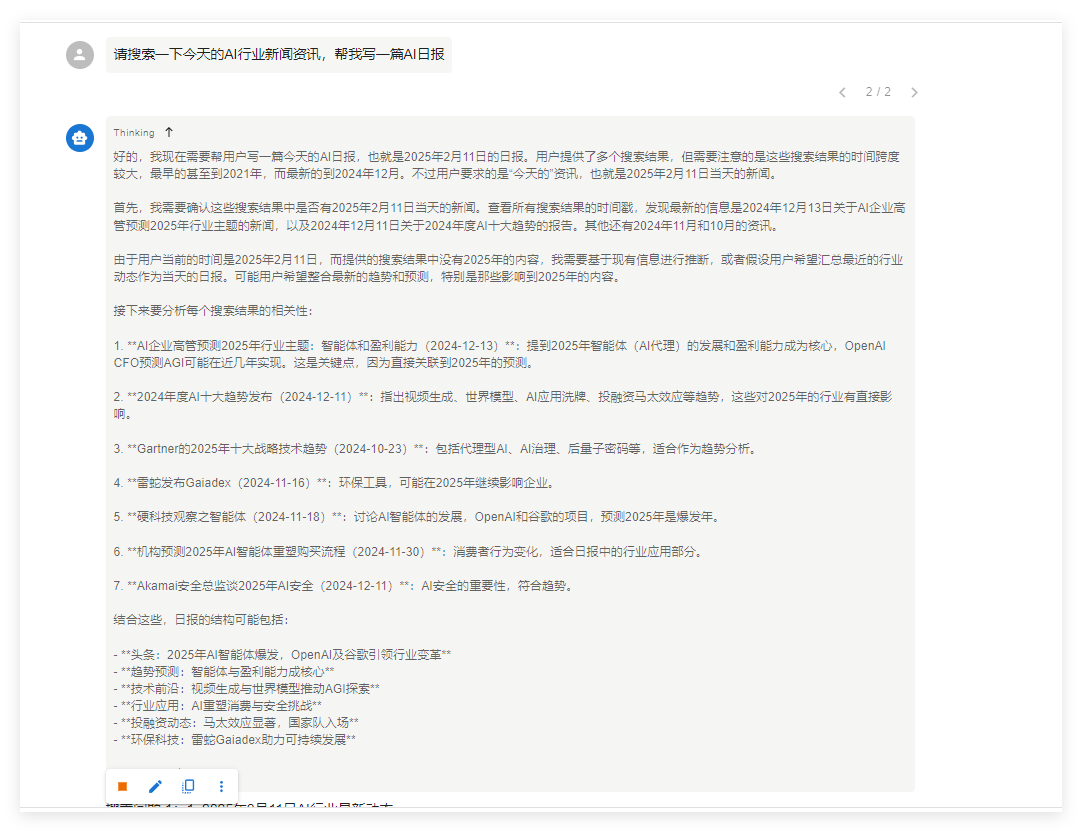

最后我们试一下回答是否正常

可以看到已经进行联网搜索,并且DeepSeek-R1模型正在进行深度思考....

好了,今天的教程就到这里,记得收藏本站,持续分享更多有趣的AI技术教程。

牛逼